Kunstmatige Intelligentie (AI) helpt mensen steeds vaker bij het nemen van beslissingen, maar overmatig vertrouwen op AI-suggesties kan leiden tot negatieve uitkomsten, van verkeerde keuzes tot levensbedreigende situaties. Het is cruciaal om overmatig vertrouwen op AI (AI overreliance) tegen te gaan en mensen in staat te stellen AI in te zetten voor betere beslissingen, vooral in risicovolle scenario's. Cognitief dwingen (cognitive forcing), gebaseerd op de psychologie van menselijke besluitvorming, is een best practice benadering als tegenmaatregel op overmatig vertrouwen op AI. Deze blog illustreert hoe cognitief dwingen kan helpen om overmatig vertrouwen op AI te voorkomen.

Mens-AI besluitvorming

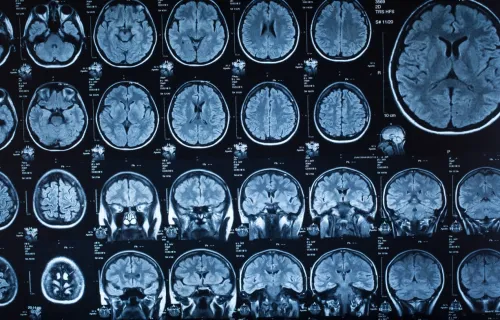

Het gebruik van AI gegenereerde suggesties voor dagelijkse taken is een regulier onderdeel van ons leven geworden. Van het kiezen van een film op onze favoriete streamingplatforms, het vinden van de snelste route naar onze bestemming, tot het krijgen van suggesties voor verjaardagscadeaus, AI is diepgeworteld in onze dagelijkse besluitvorming. Hoewel deze dagelijkse situaties relatief triviaal zijn en enige fouttolerantie toestaan, delen niet alle besluitvormingscontexten deze kenmerken. AI helpt ook bij het detecteren van hersenbloedingen1, maakt autonome ritten mogelijk en verbetert militaire besluitvorming2. In dergelijke contexten met hoge complexiteit en grote belangen is optimale besluitvorming essentieel. Het is daarom cruciaal om de dynamiek van mens-AI besluitvorming te begrijpen om wenselijke en veilige uitkomsten te waarborgen.

Het probleem van overmatig vertrouwen op AI

Het combineren van kunstmatige intelligentie met menselijke intelligentie leidt niet altijd tot betere besluitvorming. Mensen nemen vaak AI-suggesties over, zelfs wanneer deze onjuist zijn, en ze zelf een betere keuze hadden gemaakt zonder hulp van een AI-systeem. Dit fenomeen staat bekend als overmatig vertrouwen op AI (AI overreliance)3. Wanneer mensen onjuiste AI-suggesties overnemen, kunnen de resultaten desastreus zijn.

Dit probleem is vooral relevant bij complexe besluitvorming met grote belangen. Onlangs introduceerde de Europese Unie de AI Act, die AI-oplossingen classificeert op basis van risiconiveaus—minimaal, beperkt, hoog en onaanvaardbaar—die elk een op maat gemaakte aanpak voor risicobeperking vereisen4. Hoewel specifiek voor de EU, benadrukt dit kader wereldwijde zorgen over de verantwoorde inzet van AI in complexe domeinen met grote belangen. Hoog risico AI-systemen (high-risk AI systems) kunnen, ondanks de voordelen voor individuen, organisaties en de samenleving, de menselijke gezondheid en veiligheid in gevaar brengen als ze niet zorgvuldig worden beheerd. Voorbeelden van hoog risico AI-systemen zijn medische diagnostiek, luchtvaartveiligheidsprotocollen en navigatie van autonome voertuigen. Fouten in deze contexten kunnen leiden tot blijvende fysieke, financiële of reputatieschade—of zelfs tot verlies van mensenlevens.

Gezien het gebruik van hoog risico AI-systemen in besluitvorming naar verwachting zal toenemen5, wordt het aanpakken van overmatig vertrouwen op AI essentieel. Om de oorzaken van deze over-afhankelijkheid te begrijpen, verkennen we eerst de psychologische mechanismen die ten grondslag liggen aan menselijke besluitvorming en de neiging om AI-suggesties te vertrouwen—zelfs wanneer voorzichtigheid geboden zou zijn.

De rol van heuristieken

We zijn minder rationeel in onze besluitvorming dan we denken. De menselijke beperkte rationaliteit (bounded rationality) wordt veroorzaakt door ons gebruik van eenvoudige, efficiënte regels—heuristieken—bij het nemen van beslissingen. Bij heuristische besluitvorming gebruiken mensen eenvoudige, weinig inspanning vereisende (onbewuste) mentale sluiproutes in plaats van verschillende keuzeopties bewust te evalueren. In wezen nemen we genoegen met wat ‘goed genoeg’ werkt. Dit zorgt ervoor dat we onze cognitieve energie besparen, zodat we door de complexiteit van het dagelijks leven kunnen navigeren zonder overweldigd te raken door de noodzaak om elk detail te analyseren.

Het gebruik van heuristieken heeft echter zijn keerzijde. Hoewel het ons in veel situaties efficiënt laat functioneren, maakt het ons ook kwetsbaar voor beoordelingsfouten. Overmatig gebruik van deze sluiproutes kan leiden tot vergissingen, vooral in complexe of onbekende contexten waar een grondigere analyse vereist is. Deze neiging om cognitieve sluiproutes te gebruiken beïnvloedt niet alleen gewone besluitvorming, maar ook de manier waarop we met AI-systemen omgaan.

AI-systemen worden vaak gebouwd met de veronderstelling dat hun suggesties zorgvuldig door gebruikers zullen worden geanalyseerd. Deze veronderstelling blijkt echter niet altijd correct, aangezien dit proces aanzienlijke cognitieve inspanning vereist, die mensen vaak vermijden. In plaats daarvan hebben individuen de neiging om onbewust schattingen te maken van de algemene competentie van een AI-systeem3. Deze geschatte competentie van het AI-systeem wordt vervolgens gebruikt als heuristiek bij het overnemen van de door het AI-systeem gesuggereerde output. Het gevolg is dat zodra gebruikers een AI-systeem als competent beschouwen, ze geneigd zijn om te veel op de suggesties ervan te vertrouwen. Teams die AI-systemen ontwikkelen ter ondersteuning van beslissingen, zouden profiteren van het integreren van tegenmaatregelen tegen overmatig vertrouwen op AI in hun systemen.

Cognitief dwingen als oplossing

Interventies middels cognitief dwingen kunnen als maatregel tegen overmatig vertrouwen op AI worden gebruikt. Cognitief dwingen houdt in dat er ingegrepen wordt op het beslismoment om de heuristische redeneerprocessen van de mens te verstoren en de gebruiker (i.e., human-in-the-loop) te dwingen om analytisch te denken. Met andere woorden, gebruikers worden gedwongen over te schakelen van automatische (onbewuste) besluitvorming naar een meer actieve, bewuste en kritische modus. Dergelijke interventies hebben hun waarde bewezen in de medische sector, waar ze de diagnostische en behandelbesluitvorming van zowel individuele artsen als medische teams hebben verbeterd6. Recente studies hebben aangetoond dat deze techniek ook kan worden toegepast op het moment dat een mens een AI-suggestie ontvangt in een besluitvormingsproces. Dit neutraliseert het mechanisme van overmatig vertrouwen op AI, wat leidt tot een kritischere evaluatie van AI-suggesties en uiteindelijk tot betere, door AI ondersteunde beslissingen7.

Drie soorten cognitief dwingen interventies hebben bewezen effectief te zijn:

- Checklists: Deze verbeteren de besluitvorming in AI-ondersteunde omgevingen door gebruikers te verplichten belangrijke informatie te verifiëren voordat ze AI-suggesties accepteren. Bijvoorbeeld, in medische diagnostiek zorgt een checklist ervoor dat gebruikerssymptomen vergelijken met de suggesties van de AI, waardoor blinde afhankelijkheid van AI wordt voorkomen.

- Diagnostische time-outs: Pauzes in de besluitvorming waarbij gebruikers AI-suggesties kritisch heroverwegen. In klantenservice kan een medewerker bijvoorbeeld een door AI gegenereerd chatbotantwoord controleren op empathie en nauwkeurigheid, voordat deze naar de klant wordt gestuurd.

- Alternatieven uitsluiten: Gebruikers moeten andere opties evalueren en afwijzen voordat ze AI-suggesties accepteren. In de financiële sector kan dit inhouden dat investeringsopties worden vergeleken om de suggestie van de AI te valideren.

Kwaliteitsafname als bijeffect

Hoewel overmatig vertrouwen op AI leidt tot suboptimale besluitvorming, is dit niet de enige zorg. AI-modellen leren in veel gevallen van hun interacties met gebruikers, waarbij ze zich voortdurend updaten om te verbeteren. Wanneer gebruikers echter onjuiste AI-suggesties zonder twijfel accepteren, kunnen deze fouten deel uitmaken van het leerproces van het AI-model, waardoor deze na verloop van tijd minder nauwkeurig en betrouwbaar wordt. Als gevolg hiervan kan de kwaliteit van AI-suggesties afnemen, waardoor de waarde van AI in mens-AI besluitvorming uiteindelijk vermindert.

Gebalanceerde besluitvorming

Naarmate AI steeds meer geïntegreerd raakt in onze besluitvormingsprocessen, is het essentieel om een balans te vinden die de voordelen van AI maximaliseert, terwijl de menselijke beoordeling effectief wordt ingezet. Deze blog heeft de risico’s van overmatig vertrouwen op AI belicht en interventies middels cognitief dwingen zoals checklists, diagnostische time-outs en het uitsluiten van alternatieven geïntroduceerd. Deze hulpmiddelen zijn ontworpen om heuristische besluitvorming te verstoren en gebruikers te activeren om AI-suggesties kritisch te beoordelen. Door deze strategieën te integreren, kunnen besluitvormers de capaciteiten van AI benutten, terwijl ze ervoor zorgen dat menselijke inzichten en analytisch denken centraal blijven staan. Het voorkomen van overmatig vertrouwen op AI kan zelfs het leerproces van AI-modellen bevorderen, waardoor deze de tendens behouden om in de loop van de tijd te verbeteren. Het begrijpen van de psychologische factoren die hierbij een rol spelen, onderstreept het belang van menselijke cognitie in het effectief inzetten van AI. Uiteindelijk is het doel om mensen in staat te stellen weloverwogen beslissingen te nemen in samenwerking met AI, wat leidt tot slimmere, betrouwbaardere uitkomsten in diverse besluitvormingsscenario’s.

Neem contact op met CGI-expert Koen van Kan (koen.van.kan@cgi.com) om meer te leren over de kruising van Psychologie en Artificial Intelligence, en hoe dit past in CGI’s Responsible AI Framework.

Bronnen

[1] CGI. (2024). Using AI to review CT scans and detect brain hemorrhages. https://www.cgi.com/en/case-study/health/artificial-intelligence/using-ai-review-ct-scans-and-detect-brain-hemorrhages.

[2] CGI. (2024). CGI to develop AI Network for Defence and Security Accelerator Intelligent Ship Phase 2. https://www.cgi.com/uk/en-gb/news/defence/cgi-develop-ai-network-defence-and-security-accelerator-intelligent-ship-phase-2.

[3] Bansal, G., Wu, T., Zhou, J., Fok, R., Nushi, B., Kamar, E., ... & Weld, D. (2021, May). Does the whole exceed its parts? the effect of ai explanations on complementary team performance. In Proceedings of the 2021 CHI conference on human factors in computing systems (pp. 1-16).

[4] European Union. (2024). The AI Act. Human Oversight. https://ai-act-law.eu/article/14/.

[5] Gartner. (2021, June 2). Gartner predicts the future of AI technologies. Gartner. https://www.gartner.com/smarterwithgartner/gartner-predicts-the-future-of-ai-technologies.

[6] Lambe, K. A., O’Reilly, G., Kelly, B. D., & Curristan, S. (2016). Dual-process cognitive interventions to enhance diagnostic reasoning: a systematic review. BMJ Quality & Safety, 25(10), 808–820. doi:10.1136/bmjqs-2015-004417.

[7] Buçinca, Z., Malaya, M. B., & Gajos, K. Z. (2021). To trust or to think: cognitive forcing functions can reduce overreliance on AI in AI-assisted decision-making. Proceedings of the ACM on Human-computer Interaction, 5(CSCW1), 1-21.