Området avancerad dataanalys är enormt, består av massor av förvirrande verktyg och en mängd analytiker med olika typer av nischad kompetens och intresseområden. Under de senaste åren har trenden att anställa data scientists formligen exploderat. Många företag har till och med fått en dedikerad budget för AI (artificiell intelligens), vilket kan vara en av förklaringarna.

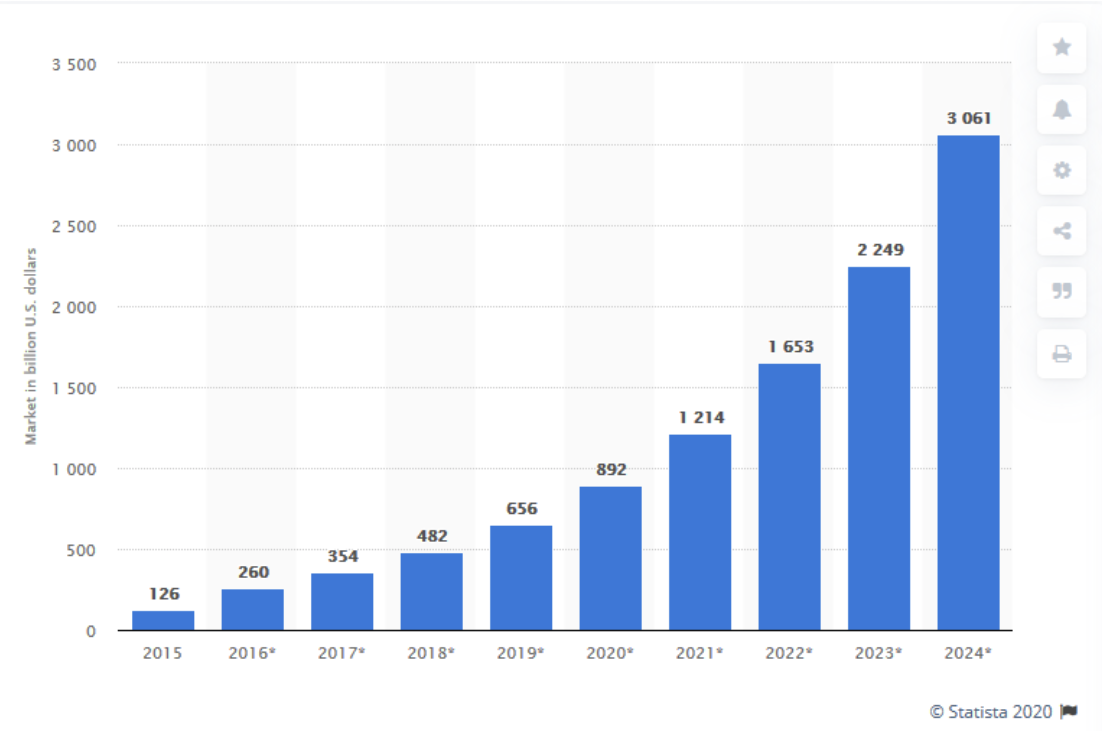

Låt oss titta på de uppskattade totala globala marknadsintäkterna för "AI" enligt Statista:

Det är uppenbart att marknaden finns där, bara man kommer åt den på något sätt. Många har försökt göra det genom att anställa en mängd data scientists.

Det har skapat en obalans i många företag. I stället för att anställa ett överskott av data scientists borde man ha anställt data engineers och analytiker.

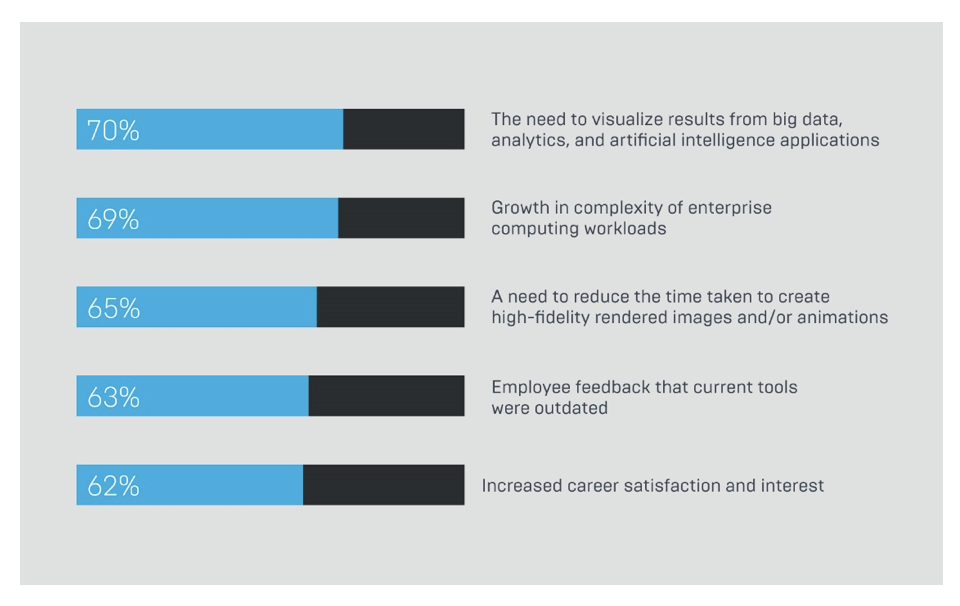

Låt oss titta på vad obalansen handlar om. Enligt Forrester Wave är det detta som marknaden säger att de vill få ut av sina data scientists:

En av fyra av uppgifterna ovan är en uppgift för en data engineer som en data scientist inte är speciellt bra på att lösa. Och den sista punkten är snarare ett önskemål av mjukare sort och inte en uppgift.

För att citera Luke Poseys artikel i Towards Data Science: - "Stop Hiring Data Scientists… Your ROI is suffering from an inability to hire properly”.

Varför? Vi har nu alla dessa företag som underutnyttjar sitt överskott av data scientists och som samtidigt inte är tillräckligt bemannade för att hantera de datatekniska problem som måste lösas.

De här företagen har sedan vänt sig till konsultföretag som har kunnat rida på vågen av att sälja buzzwords utan någon riktig definition – ungefär som 2008 när man kunde bygga upp miljardföretag enbart på buzzwordet big data.

Det värsta är att vi alla hade fel. Alla konsultbyråer, alla tjänsteföretag, produktföretag etcetera. Vi har alla varit en del av detta ... särskilt molnleverantörerna!

Som du antagligen redan har lagt märke till: Jag satte citationstecken när jag nämnde ”AI” tidigare i den här artikeln. Anledningen är enkel - de flesta av oss skäms fortfarande för det sätt som "AI" har sålts in tidigare (och till viss del fortfarande görs) - som en magisk låda som kan göra vad som helst genom en mycket liten insats av en data scientist.

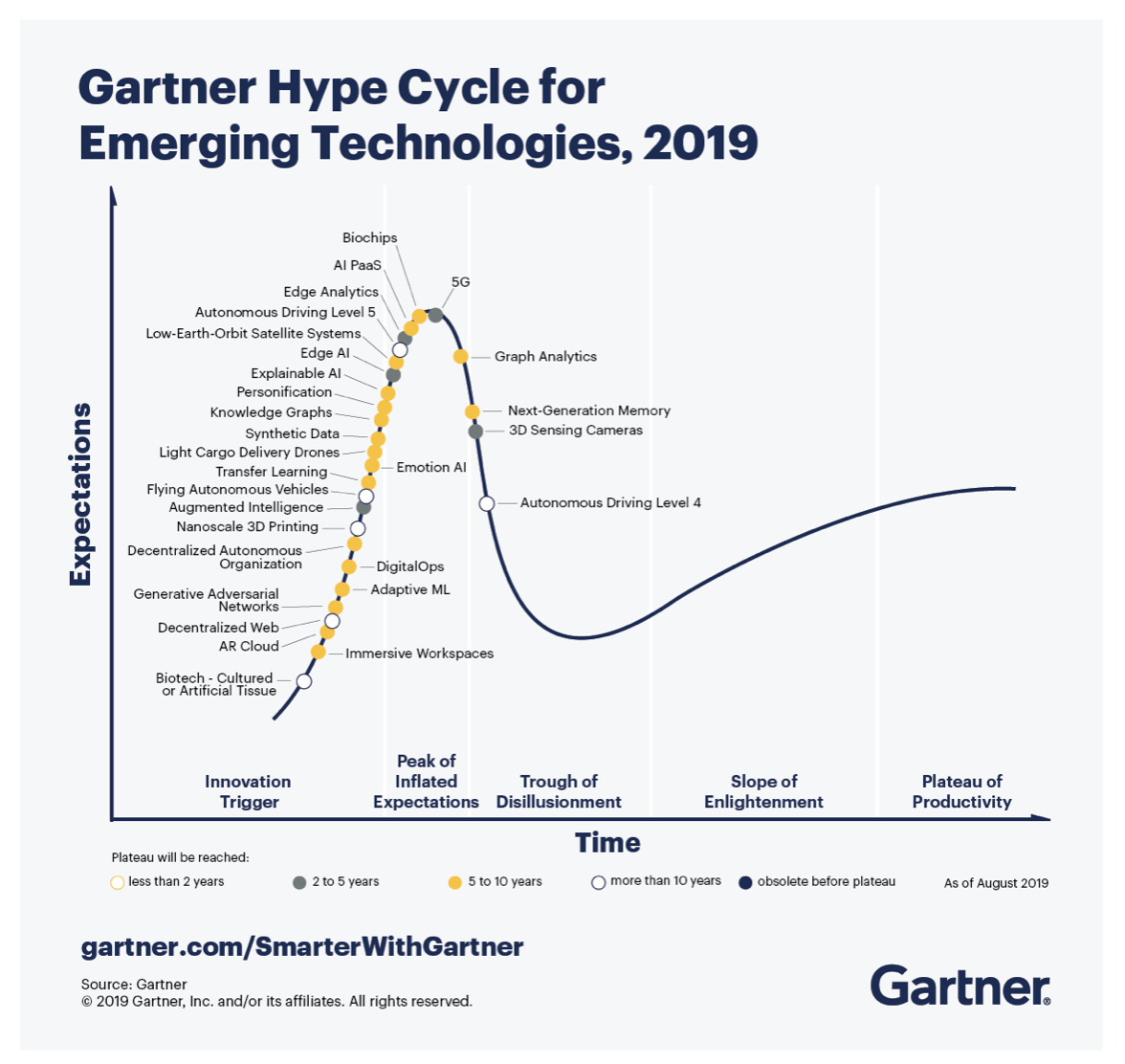

De olika typerna av teknik som har samlats under begreppet "AI" är många. Men låt oss titta på hur Gartner placerade de mest omnämnda teknikerna under hype-kurvan. Vi börjar från 2018:

Under 2018 förutsågs Deep Neural Nets (Deep Learning) ligga på produktivitetsplatån inom två till fem år, men se vad som hände i nästa rapport från Gartner Hype Curve augusti 2019:

Deep Learning finns inte ens med. Det har förmodligen redan passerat produktivitetsplatån, men du kämpar fortfarande med att komma igång, och du är inte ensam.

De få som framgångsrikt har integrerat någon form av "AI" i sin organisation har gjort det på rätt sätt. De har anställt rätt agila roller på rätt plats och vid rätt tidpunkt och vågat misslyckas ... många gånger!

Marknaden ber om hjälp och experterna föreslår strategier som är dömda att misslyckas och har gjort det sedan Machine Learning fanns med på hype-kurvan 2016.

Men marknaden är trött på alla diskussioner om att göra en förstudie, och en förstudie av förstudien, som så småningom ska leda till en förstudie som innehåller en projektplan om att implementera ”AI”. Och varför säljer vi "AI" innan vi har någon kunskap inom det område vi ska arbeta inom?

Glöm inte att "AI" inte löser allt. Ofta handlar det om optimeringsproblem som kan lösas med rätt användning av matematik och statistik. Vi måste ändra detta och vi måste ändra det nu!

Det finns en mycket uppenbar lösning - Agila DataOps-team. När du börjar din transformeringsprocess och är redo att ta dina första steg, kom ihåg: du kommer att misslyckas. Det viktiga är dock att du misslyckas snabbt. Det finns en nästintill obegränsad mängd data men betydligt färre insikter.

För andra gången i den här artikeln citerar jag Luke Posey:

"When a company has good Data Engineering, the models tend to build themselves. When a company has great data culture, the insights tend to find themselves".

Du har antagligen en mängd data att ösa över alla data scientists som passerar din tröskel, och många data scientists föredrar faktiskt att jobba på det sättet - att försöka hitta ett guldkorn i ett stort berg med data. Men det är däremot ingen vinnande strategi. Du måste definiera ett problem, ha en teori om vad du letar efter och ha ett tydligt mål som du arbetar mot.

För det mesta behöver du ett ganska stort team för att täcka alla typer av datatekniska och datavetenskapliga uppgifter du kommer att stöta på, och det är här vi som konsultbyrå kan hjälpa dig på ett effektivt sätt.

Vår affärsmodell är att vi kan tillhandahålla ett komplett sprint-team med många olika typerna av förmågor som du kommer att behöva för ett lyckat projekt eller program.

Inför varje sprint planeras nästa sprint och uppskattade resurser fördelas för de förväntade uppgifterna.

På så sätt säkerställs att rätt kompetens tilldelas rätt uppgift på rätt tid, vilket gör ditt projekt mer effektivt genom att tillåta dig misslyckas snabbare och om och om igen tills du hittar de ovärderliga insikter som du är ute efter.

Lägg dock inte alla dina ägg i samma korg. DataOps låter konsulter arbeta nära din organisation, IT-avdelning, BI-avdelning eller vem som nu har den domänkunskap som behövs för att göra ditt avancerade analysprojekt framgångsrikt.

Under projektets gång kan vi hjälpa dig med rådgivningstjänster på en mer övergripande nivå som att välja rätt plattform för dina behov inom data science och data engineering eller för arkitekturdesign för att anpassa plattformen till din organisation.

För att förstå värdet av att anlita ett DataOps-team, låt oss gå in på hur AI engineering fungerar.

Det första exemplet som vi vill lyfta är forskningsartikeln ”Engineering AI Systems: A Research Agenda” av Jan Bosch, Ivica Crnkovic och Helena Holmström Olsson.

Den inre djupare blå cirkeln är data scientist-specifika uppgifter. Den andra, lite ljusare centrerade cirkeln är generiska datatekniska uppgifter, och de yttre cirklarna är domänspecifika uppgifter för datatekniker.

Om vi bryter ner det aningen och tittar på utvecklingsmodellen för AI:

Detta förklarar arbetsflödet för ett DataOps-, SciOps- eller MLOps-team ganska bra.

Experiment och prototyper

Det är här när dina team experimenterar med befintliga datamängder, det är ett sätt att formulera idéer och teorier men också en möjlighet att anpassa ditt företag till de möjliga insikterna.

Det kan också vara ett sätt att inspirera dina kamrater eller dina chefer.

Kanske skapar du en liten ML / DL-prototyp som visar upp en ny möjlig driftsmodell?

I detta skede är dina resultat inte operativa. Du delar resultatet med det företag som du har lagt upp en strategi tillsammans med.

Icke-kritisk distribution

Ditt team är nu nöjda med de första resultaten, du driftsätter din modell till ett så kallat ”Dark Production” (ett område av produktionsmiljön som bara du och ditt team har åtkomst till och modellen kan agera som om det vore i produktion) där modellen inte stör något i affärskritiska system. Detta är också stadiet där vi börjar inse värdet av själva modellen.

Kritisk distribution

När du och ditt team börjar få förtroende för modellen börjar du integrera den i dina affärskritiska system. Det är här du behöver en korrekt livscykelhantering för din modell. Om din modell misslyckas så misslyckas även ditt affärskritiska system.

Cascading Deployment

När du har fått ett så stort förtroende för din modell att du kan börja basera andra modeller utifrån output från densamma, blir det allt viktigare att övervaka och se till att modellen fungerar korrekt och att datakvaliteten är hög.

Det är nu du behöver ett DataOps-team för att hantera din pipeline, övervaka modellerna och validera dina inkommande data.

Autonoma ML/DL-komponenter

Detta definieras som det sista steget i forskningsartikeln ”Engineering AI Systems: A Research Agenda”. Det är när du har utvecklat dina modeller till en nivå där modellerna övervakar sitt eget beteende och sin egen prestanda. Det är nu du behöver ha ett proaktivt DataOps, MLOps eller SciOps-team på plats.

Vårt löfte till dig är att vi inte lovar något slags ”magi med AI”. Däremot följer vi en process och ett nytt ramverk som har utvecklats av CGI Data Advantage.

Här får du en mer djupgående förståelse av vårt övergripande Data Advantage-ramverk.